计算

样本标准偏差的平方,即:

S2=∑(-)2/(n-1)

两组数据就能得到两个S2值

F=S2/S2'

然后计算的F值与查表得到的F表值比较,如果

F < F表 表明两组数据没有显著差异;

F ≥ F表 表明两组数据存在显著差异。

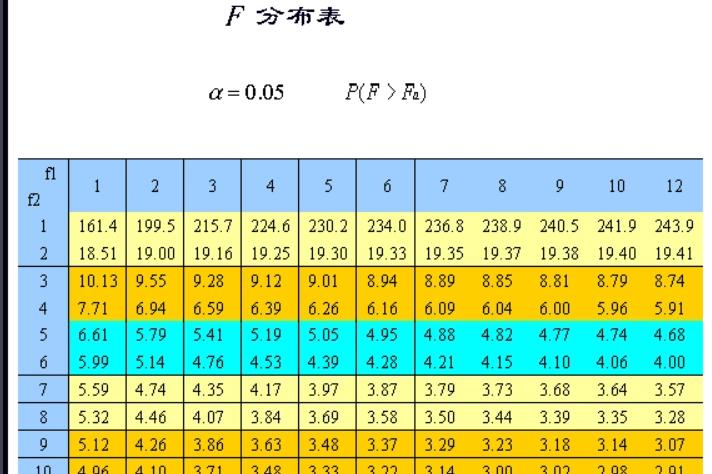

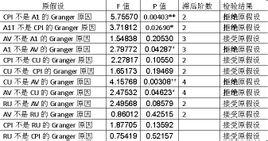

表格

置信度95%时F值(单边)

适用场合

通常的F检验例子包括:

假设一系列服从正态分布的母体,都有相同的标准差。这是最典型的F检验,该检验在方差分析(ANOVA)中也非常重要。

假设一个回归模型很好地符合其数据集要求,检验多元线性回归模型中被解释变量与解释变量之间线性关系在总体上是否显著。

注意事项

F检验对于数据的正态性非常敏感,因此在检验方差齐性的时候,Levene检验, Bartlett检验或者Brown–Forsythe检验的稳健性都要优于F检验。 F检验还可以用于三组或者多组之间的均值比较,但是如果被检验的数据无法满足均是正态分布的条件时,该数据的稳健型会大打折扣,特别是当显著性水平比较低时。但是,如果数据符合正态分布,而且alpha值至少为0.05,该检验的稳健型还是相当可靠的。

若两个母体有相同的方差(方差齐性),那么可以采用F检验,但是该检验会呈现极端的非稳健性和非常态性,可以用t检验、巴特勒特检验等取代。

关系

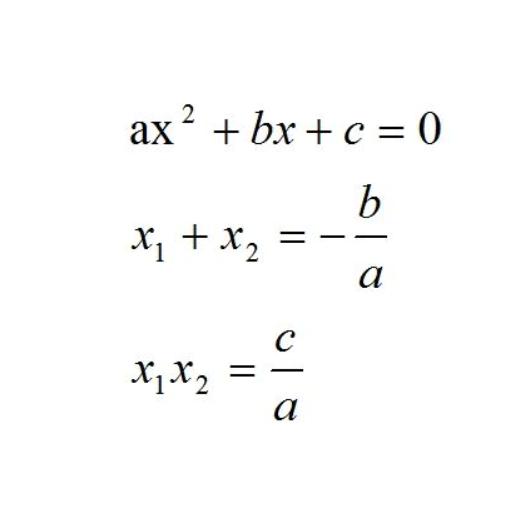

F检验的分子、分母其实各是一个卡方变数除以各自的自由度。

F检验用来检验单一变数可否排除于模型外时, F=t2。